4.600 GPUs NVIDIA conectadas: o supercomputador que vai acelerar a próxima geração de modelos da OpenAI

A Microsoft inaugurou o que pode ser considerado o maior salto de infraestrutura para inteligência artificial da história: um supercomputador em escala de produção com mais de 4.600 GPUs NVIDIA GB300 NVL72, baseadas na arquitetura Blackwell Ultra. O cluster, já operacional no Azure, foi projetado exclusivamente para acelerar os workloads da OpenAI e permitir o treinamento de modelos com centenas de trilhões de parâmetros em dias, não em semanas. Esta é a primeira vez que um sistema dessa magnitude é entregue em produção, marcando um novo padrão para computação acelerada e consolidando a parceria estratégica entre Microsoft, NVIDIA e OpenAI.

Another first for our AI fleet… a supercomputing cluster of NVIDIA GB300s with 4600+ GPUs and featuring next gen InfiniBand.

First of many as we scale to hundreds of thousands of GB300s across our DCs, and rethink every layer of the stack across silicon, systems, and software… pic.twitter.com/EtNvnSAFr6

— Satya Nadella (@satyanadella) October 9, 2025

NVIDIA GB300 NVL72

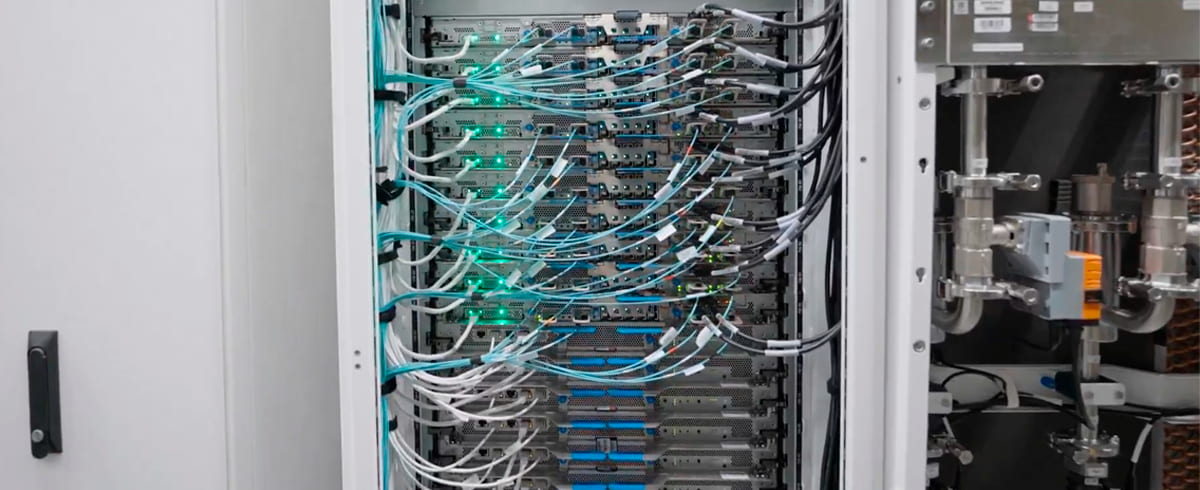

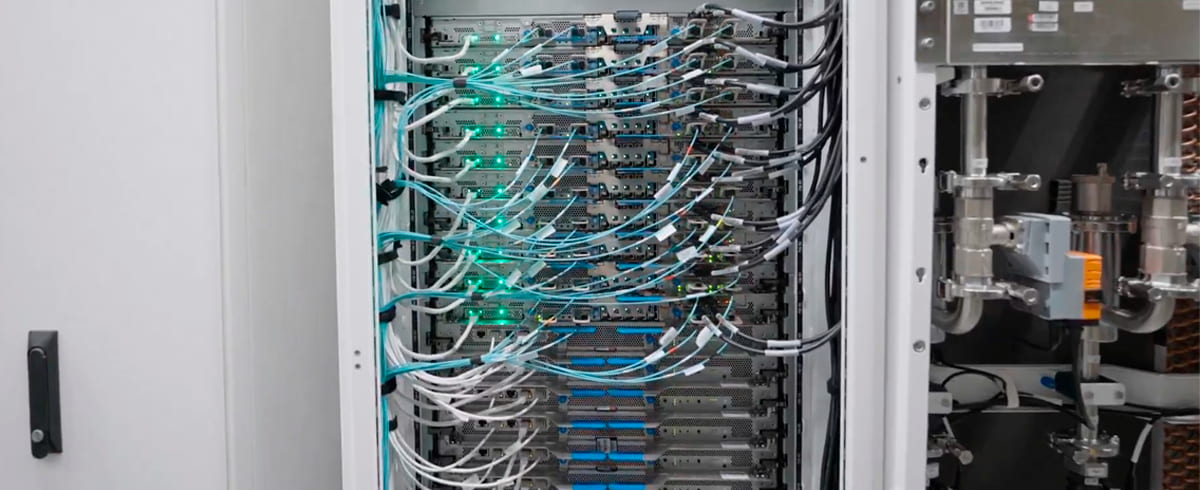

O coração deste supercomputador é o NVIDIA GB300 NVL72, uma plataforma em escala de rack que integra 72 GPUs Blackwell Ultra e 36 CPUs NVIDIA Grace baseadas em arquitetura Arm em um único sistema totalmente refrigerado a líquido. Cada rack entrega especificações que desafiam os limites da física computacional: 288 GB de memória HBM3E por GPU, 37 TB de memória rápida total, 130 TB/s de largura de banda NVLink dentro do rack e até 1.440 petaflops de desempenho em precisão FP4 Tensor Core. A conexão entre racks é feita através da rede InfiniBand NVIDIA Quantum-X800 de próxima geração, fornecendo 800 Gbps de largura de banda por GPU para escalonamento cross-rack — o dobro da largura de banda do GB200 NVL72.

A arquitetura Blackwell Ultra representa um avanço geracional em relação ao Hopper, com 208 bilhões de transistores divididos em dois dies fabricados no processo TSMC 4NP. Comparado ao H100, o GB300 oferece aceleração de camadas de atenção 2x maior e 1.5x mais operações de ponto flutuante para computação de IA. Em benchmarks de inferência, a plataforma GB300 NVL72 demonstrou até 50x de aumento no desempenho geral de saída de fábrica de IA em comparação com sistemas baseados em Hopper, combinando 10x mais responsividade por usuário e 5x mais throughput por megawatt. Para modelos de geração de vídeo baseados em difusão, o ganho chega a 30x, permitindo geração de vídeo em tempo real a partir de modelos de fundação como o NVIDIA Cosmos.

Infraestrutura projetada para IA de fronteira

The world’s first large-scale @nvidia GB300 NVL72 supercomputing cluster for AI workloads is now live on Microsoft Azure.

The deployment connects 4,600+ NVIDIA Blackwell Ultra GPUs using next-gen InfiniBand network—built to train and deploy advanced AI models faster than… pic.twitter.com/CmmDtcrlwn

— Microsoft Azure (@Azure) October 9, 2025

Construir um supercomputador dessa magnitude exigiu que a Microsoft reimaginasse cada camada da stack de infraestrutura — computação, memória, networking, datacenters, refrigeração e energia — como um sistema unificado. No nível do rack, NVLink e NVSwitch reduzem gargalos de memória e largura de banda, conectando 37 TB de memória rápida com até 130 TB/s de transferência de dados intra-rack. Para escalar além do rack, o Azure implementa uma arquitetura full fat-tree não bloqueante usando InfiniBand NVIDIA Quantum-X800, a malha de rede mais rápida disponível atualmente.

A stack co-engenheirada da Microsoft, incluindo protocolos customizados, bibliotecas coletivas e computação in-network, garante que a rede seja altamente confiável e totalmente utilizada pelas aplicações. Recursos como o NVIDIA SHARP aceleram operações coletivas e dobram a largura de banda efetiva ao realizar cálculos matemáticos diretamente no switch, tornando o treinamento e a inferência em larga escala mais eficientes. Os sistemas avançados de refrigeração do Azure utilizam unidades trocadoras de calor standalone e refrigeração de facilities para minimizar o uso de água enquanto mantêm estabilidade térmica para clusters densos e de alto desempenho como o GB300 NVL72.

Do GB200 ao GB300: evolução acelerada

Anteriormente, o Azure introduziu as máquinas virtuais ND GB200 v6, aceleradas pela arquitetura Blackwell original da NVIDIA. Essas VMs rapidamente se tornaram a espinha dorsal de alguns dos workloads de IA mais exigentes da indústria, incluindo organizações como OpenAI e Microsoft que já utilizam clusters massivos de GB200 NVL2 no Azure para treinar e implantar modelos de fronteira. Agora, com as VMs ND GB300 v6, o Azure eleva o patamar novamente, otimizando especificamente para modelos de raciocínio, sistemas de IA agêntica e IA generativa multimodal.

O GB300 representa uma evolução focada na era do raciocínio de IA, com melhorias significativas sobre o GB200: 1.5x mais desempenho de computação de IA, 288 GB de memória HBM3e por GPU (versus 192 GB no GB200), 20.480 núcleos CUDA (versus 18.432), e foco aprimorado em test-time scaling. O poder térmico gráfico (TGP) do GB300 atinge 1.400W, acima dos 1.200W do GB200, o que exige soluções avançadas de refrigeração e distribuição de energia. A Microsoft desenvolveu novos modelos de distribuição de energia capazes de suportar a alta densidade energética e o balanceamento dinâmico de carga exigidos pela classe de clusters GPU ND GB300 v6.

O contexto da corrida pela infraestrutura de IA

Este anúncio se insere na estratégia ambiciosa da Microsoft de investir US$ 80 bilhões em datacenters otimizados para IA até 2028 — o maior compromisso de infraestrutura da história da empresa. O investimento abrange 25 novas regiões do Azure na América do Norte, Europa, Ásia e África, com foco em clusters de GPUs refrigerados a líquido e de alta densidade, incluindo os chips customizados Maia 100 e Maia 200 da Microsoft. A empresa também está desenvolvendo clouds soberanas e clusters edge dedicados para indústrias reguladas, além de sistemas de energia sustentável com solar, eólica e armazenamento em bateria on-site.

Em setembro de 2025, a Microsoft apresentou seu datacenter de IA mais poderoso do mundo em Mount Pleasant, Wisconsin, equipado com a infraestrutura Fairwater que entrega 10 vezes mais capacidade computacional. Esses novos datacenters de IA fazem parte de uma rede global de datacenters Azure AI, interconectados via Wide Area Network (WAN), operando como uma única máquina de IA poderosa distribuída. Este sistema distribuído, resiliente e escalável permite que clientes aproveitem o poder de um supercomputador de IA gigante, com treinamento distribuído em larga escala através de múltiplas regiões Azure geograficamente diversas.

Leave A Comment

You must be logged in to post a comment.