Efeito Felca: Como as redes sociais podem reforçar o controle sobre a sexualização infantil?

Efeito Felca: Como as redes sociais podem reforçar o controle sobre a sexualização infantil?

No começo do mês, o youtuber Felca expôs um assunto delicado e muito importante que acabou bombando na internet, revelando perfis em redes sociais que publicam materiais de menores com conotações sexuais, alguns até vendidos em plataformas adultas. O pior? Muitos desses criadores faturam alto com isso, via monetização direta ou indireta.

A repercussão foi enorme: contas caíram, autoridades se mexeram e a imprensa cobriu o caso. Mas fica a dúvida que não cala: por que plataformas como o Instagram ainda deixam isso rolar? Vamos mergulhar no problema e em soluções práticas que poderiam mudar esse jogo, priorizando a proteção das crianças acima de tudo.

Leia também:

- Chatbots fora de controle: dos discursos de ódio aos golpes virtuais

- Apple atualiza classificação etária da App Store e traz mais controle aos pais

O problema não é só o conteúdo, mas também o algoritmo

O que Felca mostrou vai além de posts isolados – o algoritmo do Instagram joga lenha na fogueira. Bastou ele interagir com alguns conteúdos envolvendo crianças para que o feed e as recomendações inundassem com materiais semelhantes, incluindo perfis bem suspeitos. Esse “efeito bola de neve”, ou amplificação algorítmica, acontece porque o sistema é obcecado por engajamento: curtidas, comentários e compartilhamentos mandam, independentemente se o conteúdo é tóxico ou ilegal.

Para virar essa página, o Instagram poderia recalibrar seu algoritmo com foco na segurança infantil. Isso significa detectar e limitar automaticamente posts de risco, colocando a proteção à frente das métricas de viralização. Tecnologias de IA já existem para isso; basta priorizá-las e testar em escala para evitar que conteúdos prejudiciais se espalhem como vírus.

Como o próprio youtuber ressalta, o algoritmo, embora seja um robô, é criado por seres humanos e, portanto, deveria ser programado para não fazer vista grossa para esse tipo de material e principalmente existir uma sinalização para preferências desse tipo de material. É inaceitável que o algoritmo entenda vídeos de crianças em poses sugestivas como “tópicos de interesse” sem qualquer avaliação ética ou moral.

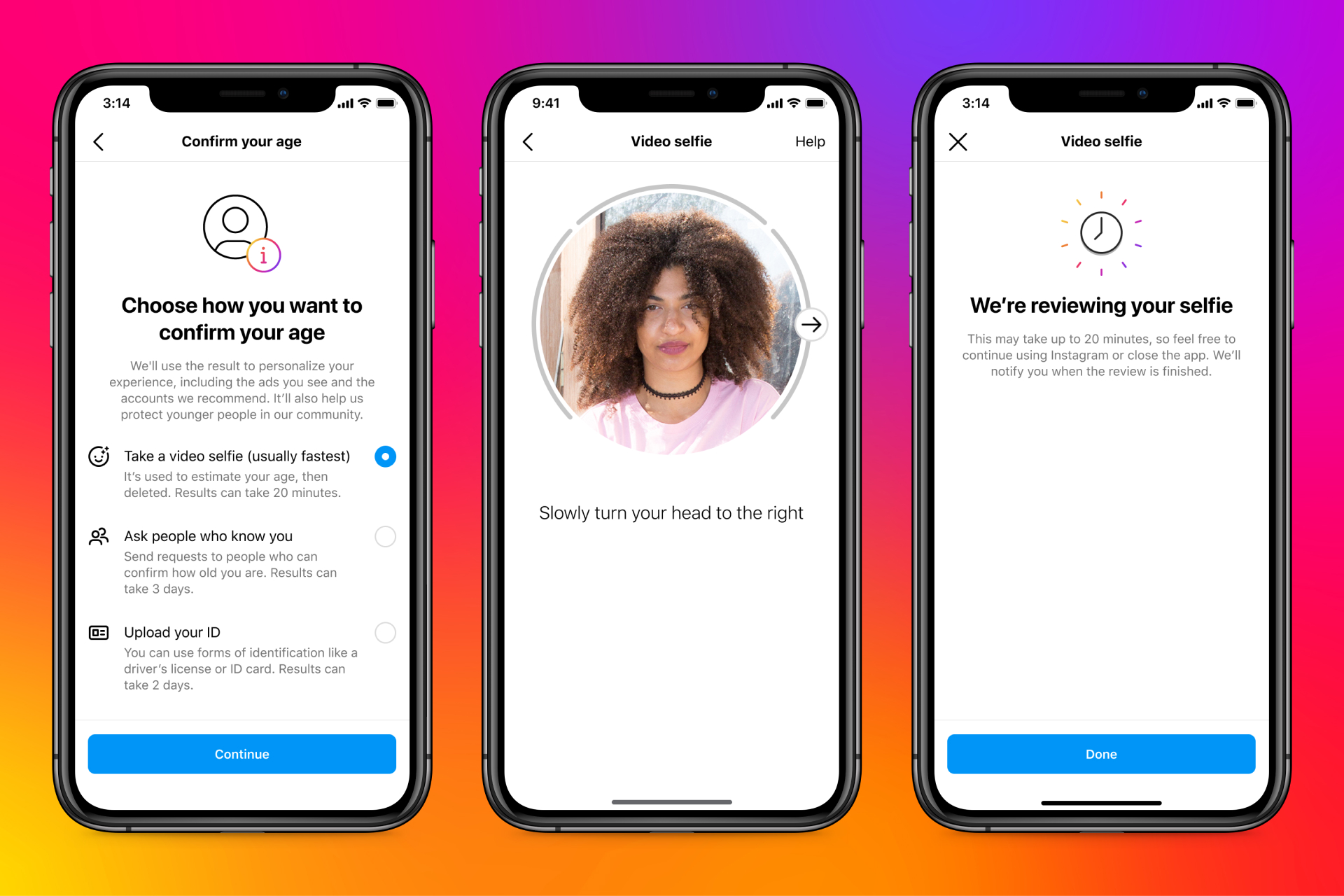

Verificação de idade que realmente funcione

Atualmente, declarar a idade no Instagram é como preencher um formulário qualquer – fácil de burlar. Crianças acessam o que não deviam, e adultos maliciosos se passam por adolescentes para postar ou interagir com conteúdos infantis. Isso abre portas para abusos que ninguém quer ver.

Uma saída viável seria uma verificação mais robusta, como cruzamento de dados ou exigência de documentos em contas que lidam com temas sensíveis ou infantis. Plataformas de streaming e pagamentos já usam métodos parecidos com sucesso. No Instagram, isso poderia ser aplicado seletivamente, como em perfis que publicam fotos de menores, garantindo que só adultos verificados gerenciem esse tipo de conteúdo e reduzindo riscos de exploração.

Monitoramento de monetização e moderação ativa com filtros

O que mais choca nas denúncias de Felca é o lucro envolvido: perfis faturando com exposição de crianças via anúncios, links para sites pagos ou vendas diretas. É como se a plataforma virasse cúmplice involuntária ao permitir isso.

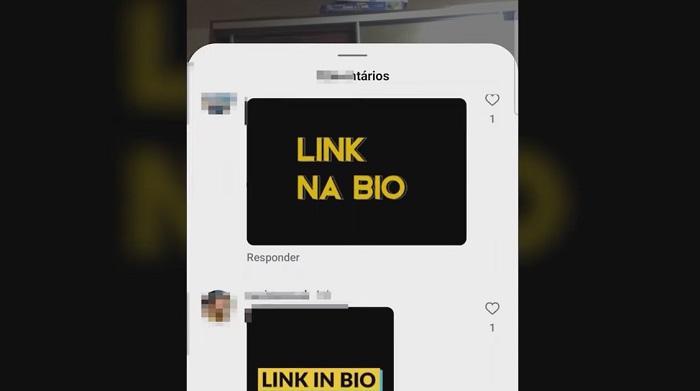

Para cortar o mal pela raiz, o Instagram poderia proibir qualquer monetização em contas de menores e fazer auditorias regulares. Isso inclui checar links na bio, campanhas patrocinadas e propagandas camufladas. Com ferramentas automáticas de rastreamento, seria possível bloquear pagamentos suspeitos na hora, desincentivando quem vê as crianças como fonte de renda.

Hoje, a moderação depende demais de denúncias dos usuários, o que é reativo e lento – especialmente em casos de exploração infantil, onde o dano já está feito antes de alguém reportar.

Investir em IA para análise de imagens, textos e padrões suspeitos faria toda a diferença: detectar roupas inadequadas em fotos de crianças, legendas sugestivas ou hashtags usadas em contextos errados, e encaminhar para revisão humana imediata. Essa abordagem proativa, combinada com equipes maiores de moderadores treinados, transformaria a plataforma em um ambiente mais seguro, prevenindo problemas antes que viralizem.

Além disso, as plataformas também deveriam procurar por padrões que ele mesmo apontou no vídeo, como por exemplo comentários ou perfis com gifs de “link in bio”, ou com palavras como “trade” (que significa troca de conteúdo pornográfico de criança). Felca sugere que as contas que usam esses códigos para direcionar para comunidades de compartilhamento de pornografia infantil deveriam simplesmente não existir.

Educação digital para pais e responsáveis

Muitos pais postam fotos “inocentes” dos filhos sem imaginar os riscos – essas imagens podem ser roubadas, manipuladas ou usadas de forma criminosa online. O desconhecimento agrava o problema, e muitas vezes isso acaba acontecendo sem querer ou sem qualquer intenção.

O Instagram poderia ajudar com alertas no upload, como pop-ups explicando perigos e sugerindo configurações de privacidade. Além disso, promover conteúdos educativos no feed, como dicas sobre exposição segura, empoderaria famílias a protegerem as crianças. É uma forma simples e impactante de construir uma comunidade mais consciente, complementando as ferramentas técnicas.

Sistema de denúncia mais rápido e específico

Denunciar algo hoje no Instagram envolve cliques intermináveis, e o feedback é vago – você reporta e fica no vácuo, sem saber o que acontece depois.

Melhorar isso com botões dedicados a “sexualização de menores”, análise prioritária e integração com autoridades seria um avanço enorme. Casos graves poderiam ser encaminhados diretamente para investigações policiais, acelerando respostas e aumentando a confiança dos usuários. Essa transparência incentivaria mais denúncias, criando um ciclo virtuoso de proteção.

Um problema que exige ação imediata

O vídeo de Felca, que já ultrapassou milhões de visualizações e levou a investigações como a do influencer Hytalo Santos, é só a ponta do iceberg. Ele escancara como redes sociais, apesar de regras e equipes de moderação, ainda falham em barrar a exploração infantil e o lucro gerado por ela. Confira ele na íntegra abaixo ou clique aqui para assistir no Youtube.

Proteger crianças online não pode ser opcional – tem que ser prioridade ética e técnica. Ajustes em algoritmos, verificações mais fortes, barreiras à monetização e investimentos em educação são urgentes. Enquanto isso não rola, incidentes como esses vão se repetir, tratando a infância como mercadoria. Nenhuma sociedade moderna deveria aceitar isso, está na hora das plataformas, como o Instagram, darem um passo à frente e realmente agirem.

Leave A Comment

You must be logged in to post a comment.